RL Algorithms: PPO-RLHF & GRPO-family

导言

- RLHF 利用复杂的反馈回路,结合人工评估和奖励模型来指导人工智能的学习过程。(RLHF = 人类偏好数据 + Reward Model + RL(如 PPO), 所以RLHF是RL的一种实践方式)

- 尽管DPO相对于PPO-RHLF更直接,但是(Reinforcement Learning from Verifiable Rewards (RLVR))往往效果更好;

- 而RLVR算法在 2025年的GRPO提出后,其变种和应用范围迎来了井喷爆发。

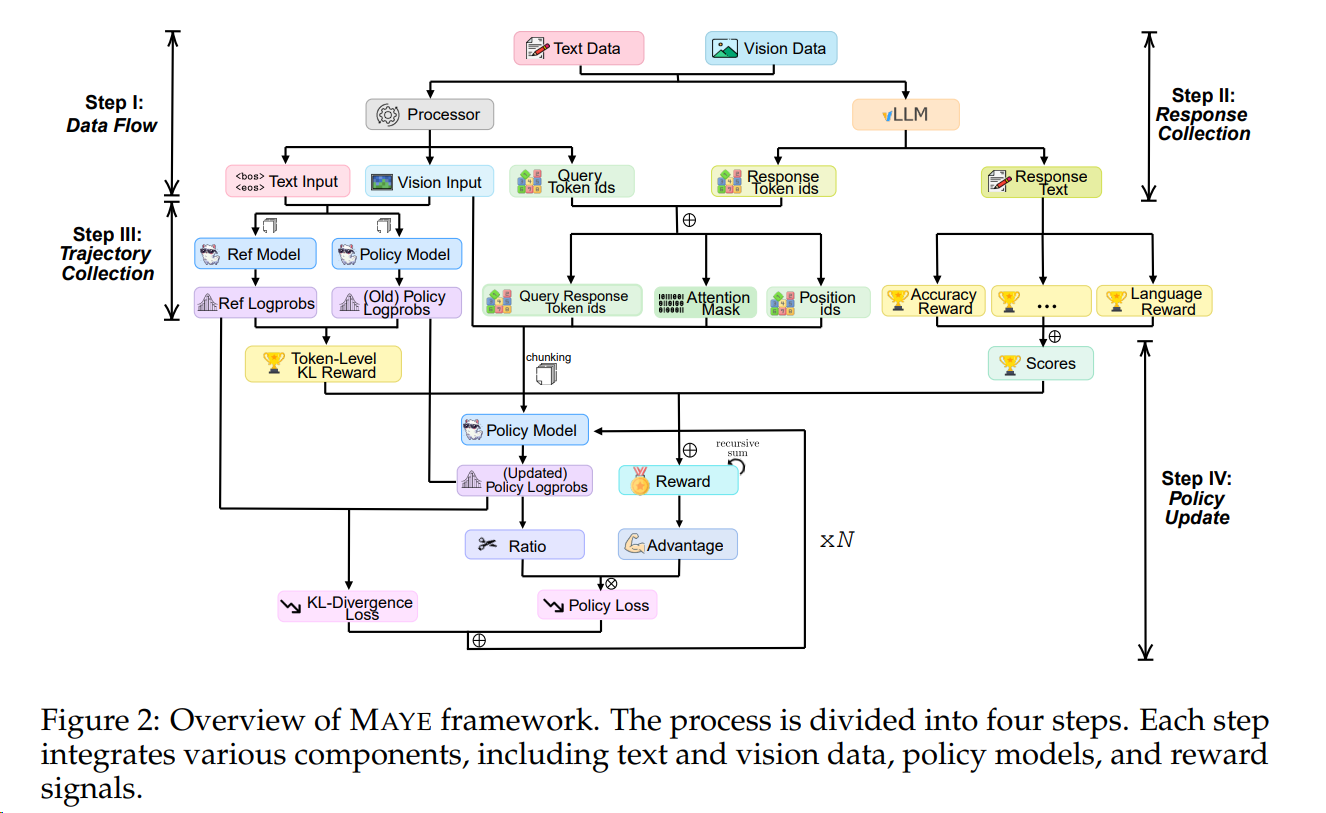

- 本文详细介绍 PPO、GRPO以及DAPO。

必看好文6