笔记¶

Pip Cache

导言

VeRL场景开发时,安装包特别多和复杂:

- CANN

- torch\torch_npu

- vllm\vllm_ascend

- MindSpeed\megatron

- transformer

开发时还要pip install -e . 还要修改代码。

传统的思路是docker镜像或者conda打大包,但是这种包一个就是20GB+,但是这是商发时的策略,开发时即使只是修改一行,但是还是要重新出一个20GB大包。

思路是借助并加速pip的原子化构建:

- 在内网服务器上建立一个pip包缓存站,

- 不仅能缓存官方包,

- 自己修改的代码包也能提交。

- 最终实现,除了CANN安装,其余pip包,一行

pip intall -r requirements.txt就行。

World Model/UFMs/Omni-Modal: AR vs DiT

导言

视觉领域的GPT moment要来了吗?4

- World Model: (e.g., Emu3.5)

- Unified Foundation Models, UFMs,强调视觉能力的闭环。证明模型能像“看懂”图片一样“画出”图片。(e.g.,Bagel, Lumina, Emu3.5)

- Omni 强调交互能力的闭环。证明模型能像真人一样,具备实时、全感官的反应。图片生成暂时不是必须的(e.g.,Qwen-3-Omni、longcat-omni), 但是也能支持(e.g., Ming-Omni)

当前多模态设计中AR和DiT的组合关系,单独学习一下

Pytorch 7 :Memory Optimization(Freeing GPU/NPU Memory Early)

导言

- 对于不使用的python对象,如何释放?

- python 的对象管理机制

- del,empty_cache , gc_collect的原理

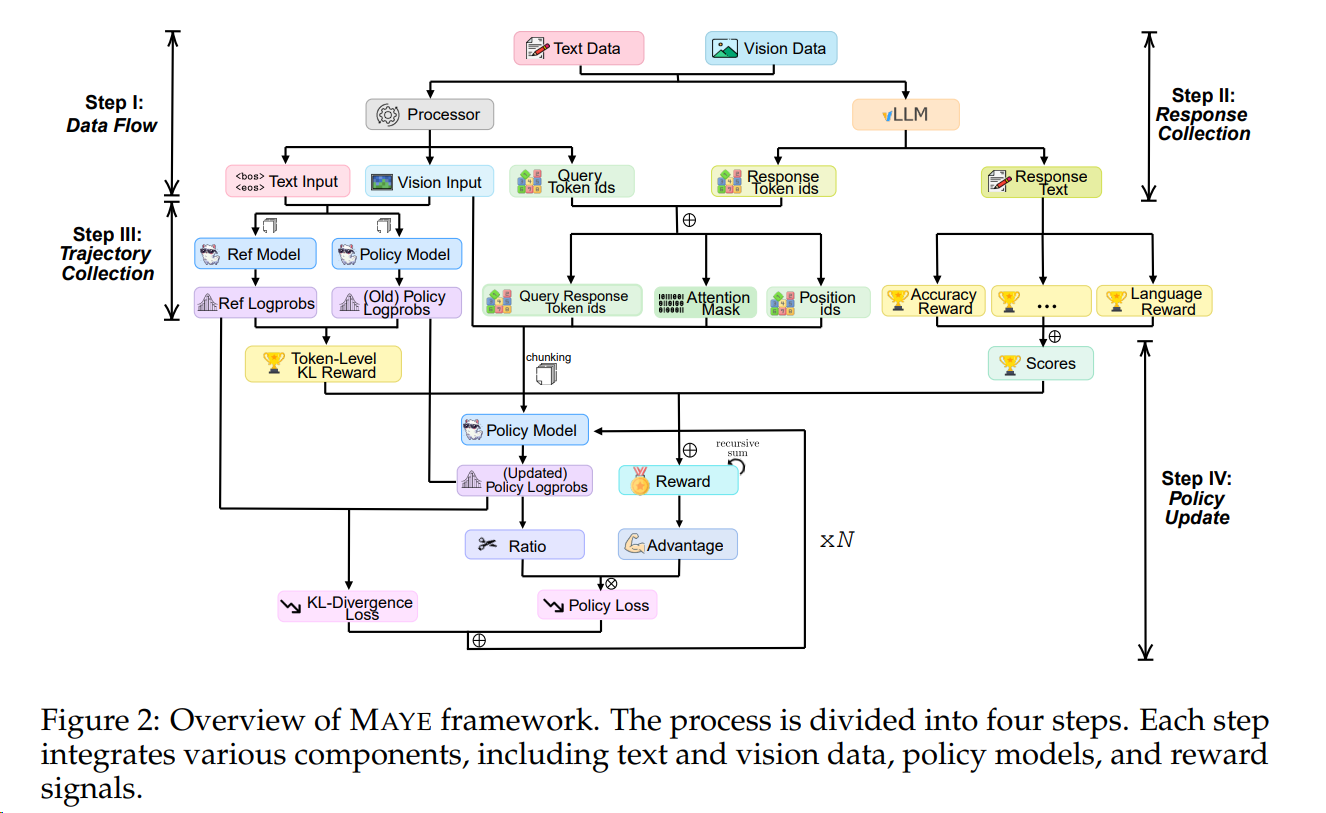

RL Algorithms: PPO-RLHF & GRPO-family

导言

- RLHF 利用复杂的反馈回路,结合人工评估和奖励模型来指导人工智能的学习过程。(RLHF = 人类偏好数据 + Reward Model + RL(如 PPO), 所以RLHF是RL的一种实践方式)

- 尽管DPO相对于PPO-RHLF更直接,但是(Reinforcement Learning from Verifiable Rewards (RLVR))往往效果更好;

- 而RLVR算法在 2025年的GRPO提出后,其变种和应用范围迎来了井喷爆发。

- 本文详细介绍 PPO、GRPO以及DAPO。

必看好文6